ایتنا - دیپفیکهای هوش مصنوعی اغلب برای ایجاد آسیب استفاده میشوند، اما روشهای موجود طراحی شده برای کاهش یا جلوگیری از تقلب باید برای محافظت در برابر این فناوری کافی باشد.

دریافت لینک صفحه با کد QR

دریافت لینک صفحه با کد QR

آیا درباره خطرات جعل عمیق اغراق میشود؟

سايت خبری ايتنا , 17 اسفند 1402 ساعت 6:10

ایتنا - دیپفیکهای هوش مصنوعی اغلب برای ایجاد آسیب استفاده میشوند، اما روشهای موجود طراحی شده برای کاهش یا جلوگیری از تقلب باید برای محافظت در برابر این فناوری کافی باشد.

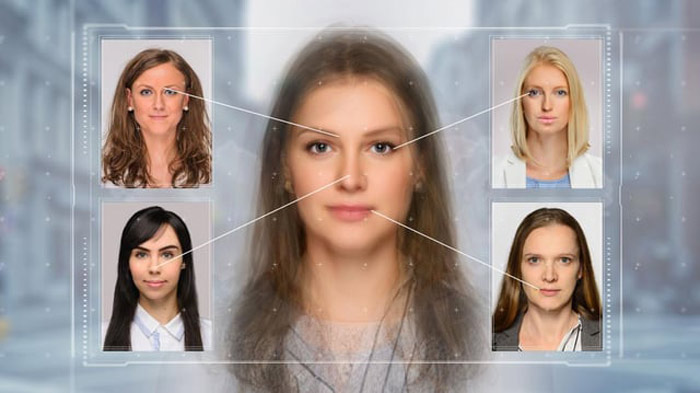

در عصر دیجیتالی که در آن زندگی میکنیم، مرز بین واقعیت و فانتزی مبهم شده است. ظهور فناوری جعل عمیق (دیپ فیک) نگرانیهای عمده و بحث های جنجالی را در مورد صحت محتوای بصری ایجاد کرده است.

همانقدر که تصاویر دستکاری شده پیچیدهتر میشوند، درک فناوری زیربنایی و تاثیر بالقوه آن ضروریتر میشود، به خصوص که ظهور جعل عمیق پیامدهای زیادی برای جنبههای مختلف جامعه از جمله سیاست، روزنامه نگاری، سرگرمی و حریم خصوصی دارد.

با کنترلهای صحیح و هوشیار بودن نسبت به خطرات احتمالی جعل عمیق، میتوانیم این طوفان حوزه تکنولوژی را پشت سر بگذاریم.

این نکته را باید در نظر داشت که فناوری دیپ فیک، پدیده نوظهوری نیست، بلکه سالهاست در استودیوهای فیلمسازی هالیوود استفاده میشود، اما اکنون از طریق اپلیکیشنهای تجاری در دسترس همگان قرار گرفته است که منجر به افزایش حجم محتوای جعلی در حال گردش در فضای مجازی شده است.

هنگامی که از دیپ فیک برای تبلیغ اطلاعات نادرست و گمراه کننده استفاده میشود، دانستن اینکه ابزارهایی در حال توسعه هستند که ویدیوهای اصلاح شده توسط هوش مصنوعی را شناسایی میکنند، نیز امری ضروری است.

البته چیزی که امیدوار کننده است، همگرایی غولهای فناوری مانند گوگل، متا، اوپنایآی، مایکروسافت و دیگر شرکتها است که صریحا اعلام کردند باید روشهای جدیدی برای محدود کردن گسترش فناوری دیپفیک ایجاد شود. مانند افزودن برچسبها واترمارک نامرئی روی ویدئوها و تصاویری که با استفاده از دیپفیک و هوش مصنوعی ایجاد یا اصلاح میشوند.

یکی دیگر از عوامل اطمینان بخش این است که اخیرا قانونی پیشنهادی که توسط کمیسیون تجارت فدرال ایالات متحده تعیین شده است به زودی برای کمک به جلوگیری از تقلب از طریق هوش مصنوعی اجرایی میشود.

متا نیز به زودی شروع به برچسب گذاری تصاویر جعل عمیق یا تولید شده توسط هوش مصنوعی در پلتفرمهای خود در فیسبوک، اینستاگرام و Threads به عنوان "تولید شده توسط هوش مصنوعی" میکند تا آنها را از محتوای واقعی متمایز کند.

علاوه بر گسترش آگاهی فردی در بین کاربران اینترنت، اکثریت مردم در حال حاضر صحت محتوا را قبل از اشتراکگذاری تأیید میکنند و این امر نقش اساسی در کاهش خطرات ناشی از جعل عمیق دارد.

تشخیص جعل عمیق به طور فزایندهای دشوار شده اما غیرممکن نیست. در اینجا برجسته ترین روشها آمده است:

کد مطلب: 77790

آدرس مطلب: https://www.itna.ir/news/77790/آیا-درباره-خطرات-جعل-عمیق-اغراق-می-شود